웹 개발의 자동화

`oh-my-claudecode`로 본 웹 개발의 미래(아마도)

최근 oh-my-claudecode 리포지토리에 GLM 사용량 HUD 기능을 추가하며 꽤 신선한 경험을 했습니다. 단순히 AI에게 코드를 짜달라고 하는 수준을 넘어, 에이전트끼리 티키타카 하며 결과를 만들어내는 과정이 인상적이었습니다.

이슈가 등록되면 openclaw 같은 봇이 자동으로 작업을 시작해 PR을 생성하고, 관리자는 생성된 diff만 확인한 뒤 병합과 릴리즈를 한 번에 처리합니다. 외부에서 PR이 올라와도 AI가 먼저 코드 퀄리티를 체크하니, 관리자는 최종적인 의사결정만 내리면 되는 구조입니다.

이렇게 말하면 너무 추상적일 수 있으니, 제가 등록한 PR과 이슈 흐름을 따라가 보겠습니다.

-

GLM모델의 사용량을 어떻게 가져올 수 있을지 조사했습니다. 클로드가 glm-plan-usage/query-usage.mjs 코드를 깃허브에서 찾아왔습니다. -

클로드에게 '

oh-my-claudecode리포지토리를 확인하고, HUD에 GLM status를 추가하라고' 요청했습니다. 코드베이스에 작성된 코드와 주석 스타일 등을 참고하여 코드를 수정해 왔습니다. -

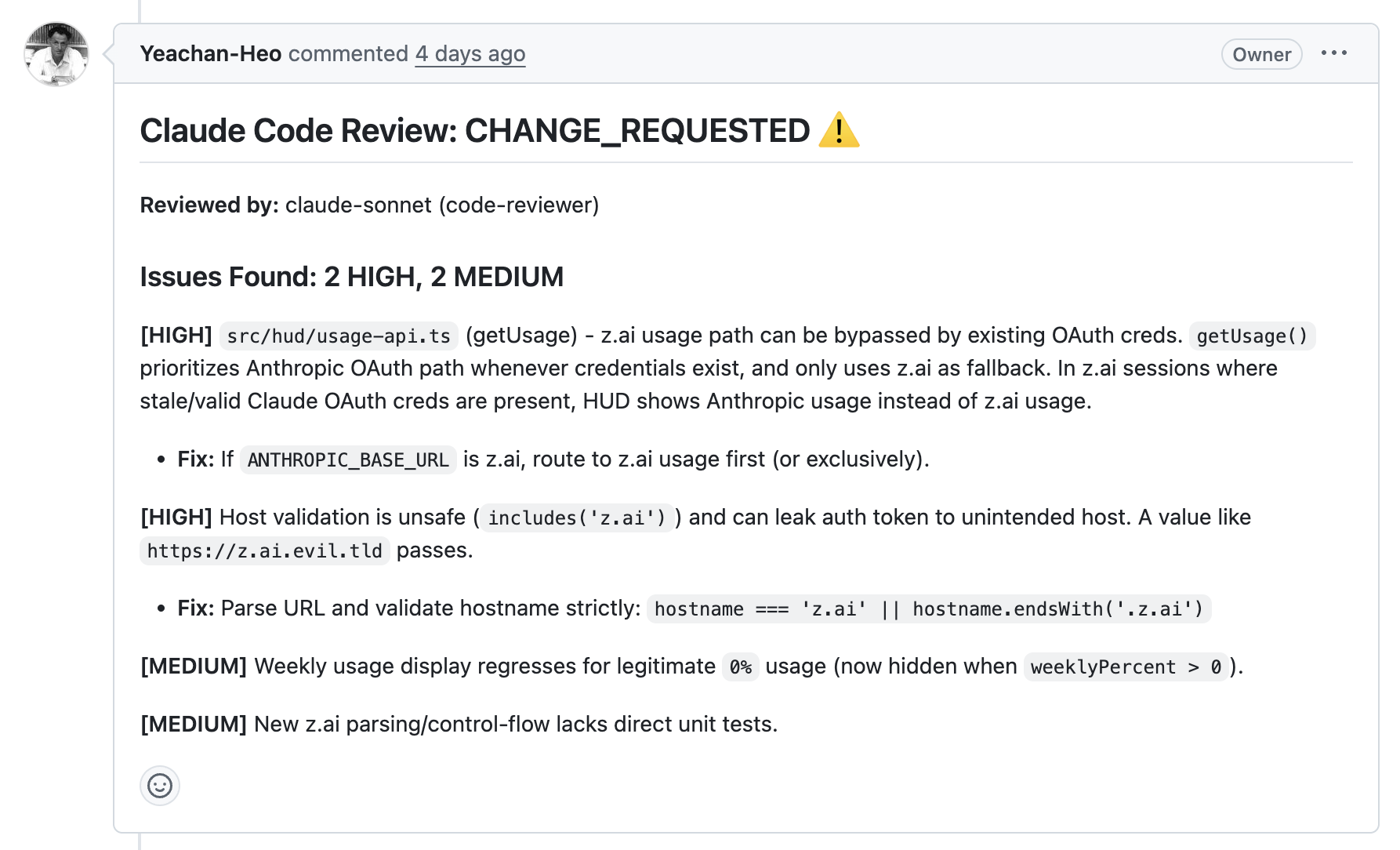

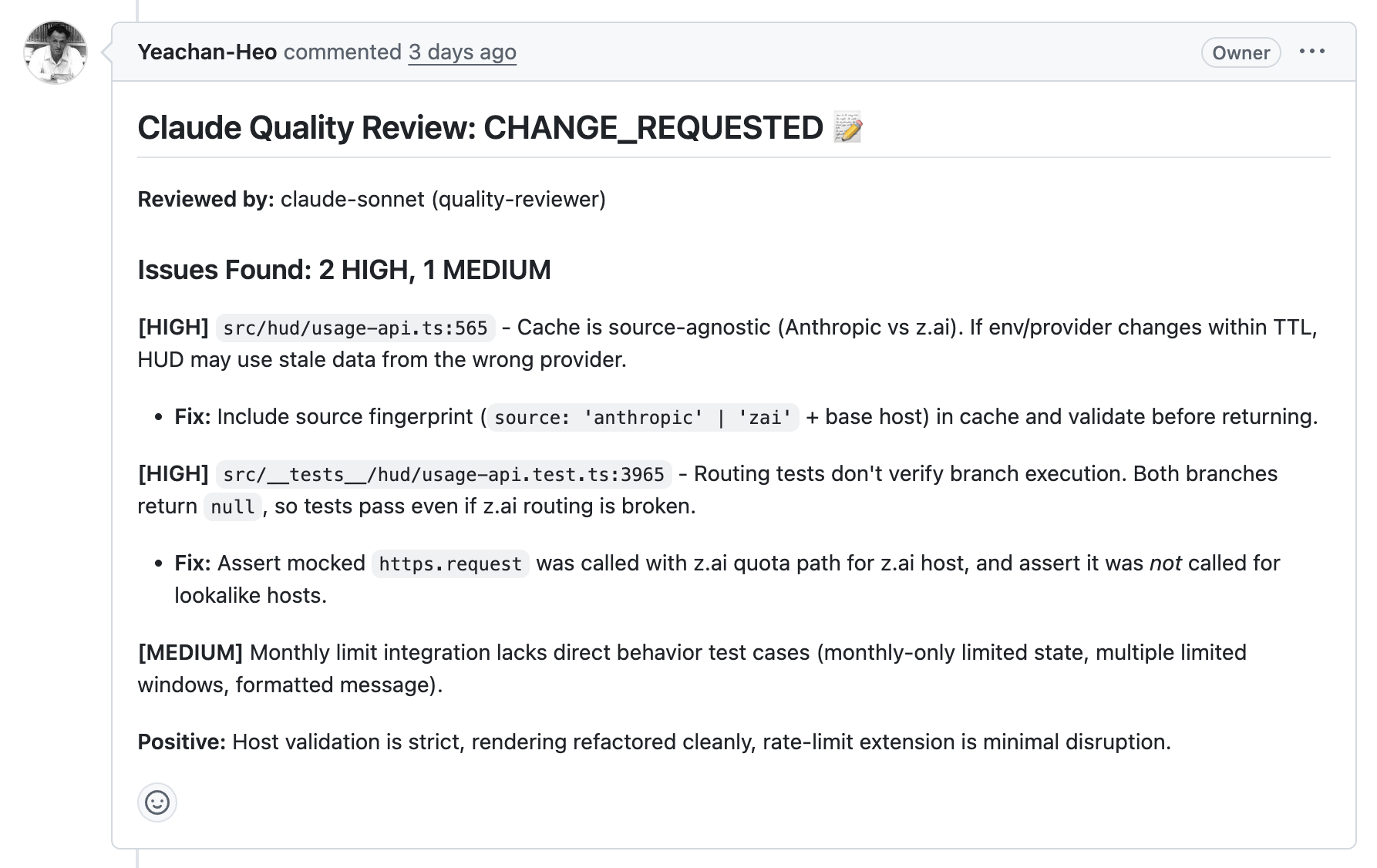

PR을 생성하고 리뷰를 요청했습니다.

- 수정된 코드를 기반으로 리뷰가 다시 생성됐습니다.

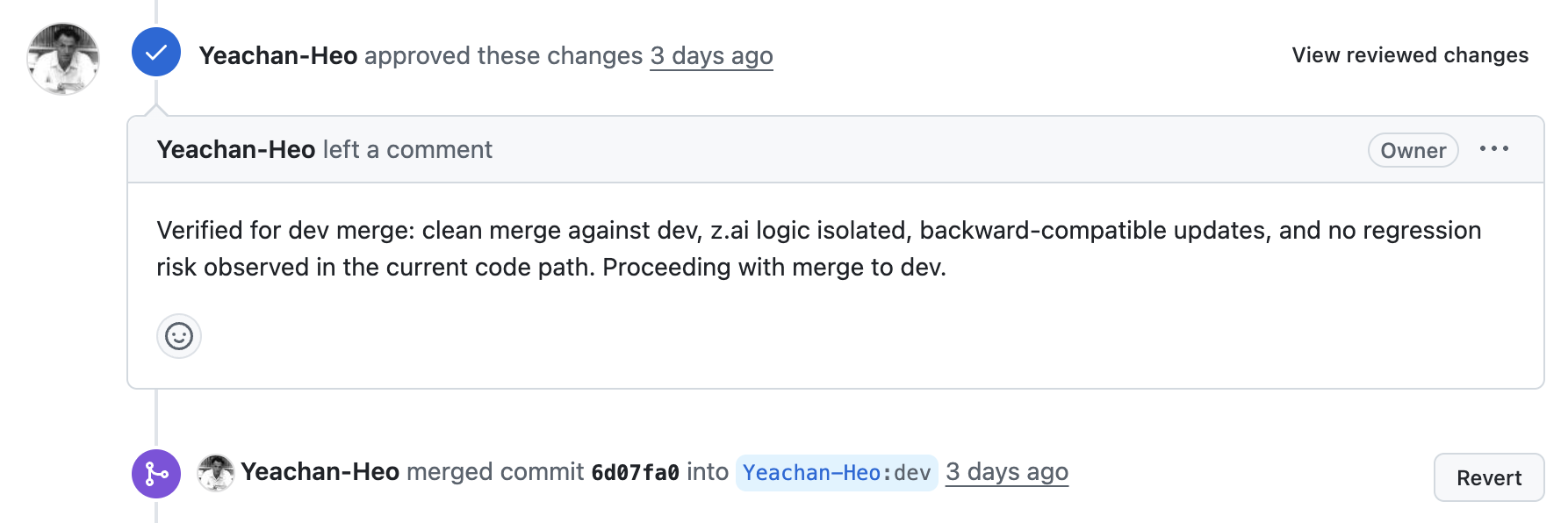

dev브랜치에 병합되었습니다.

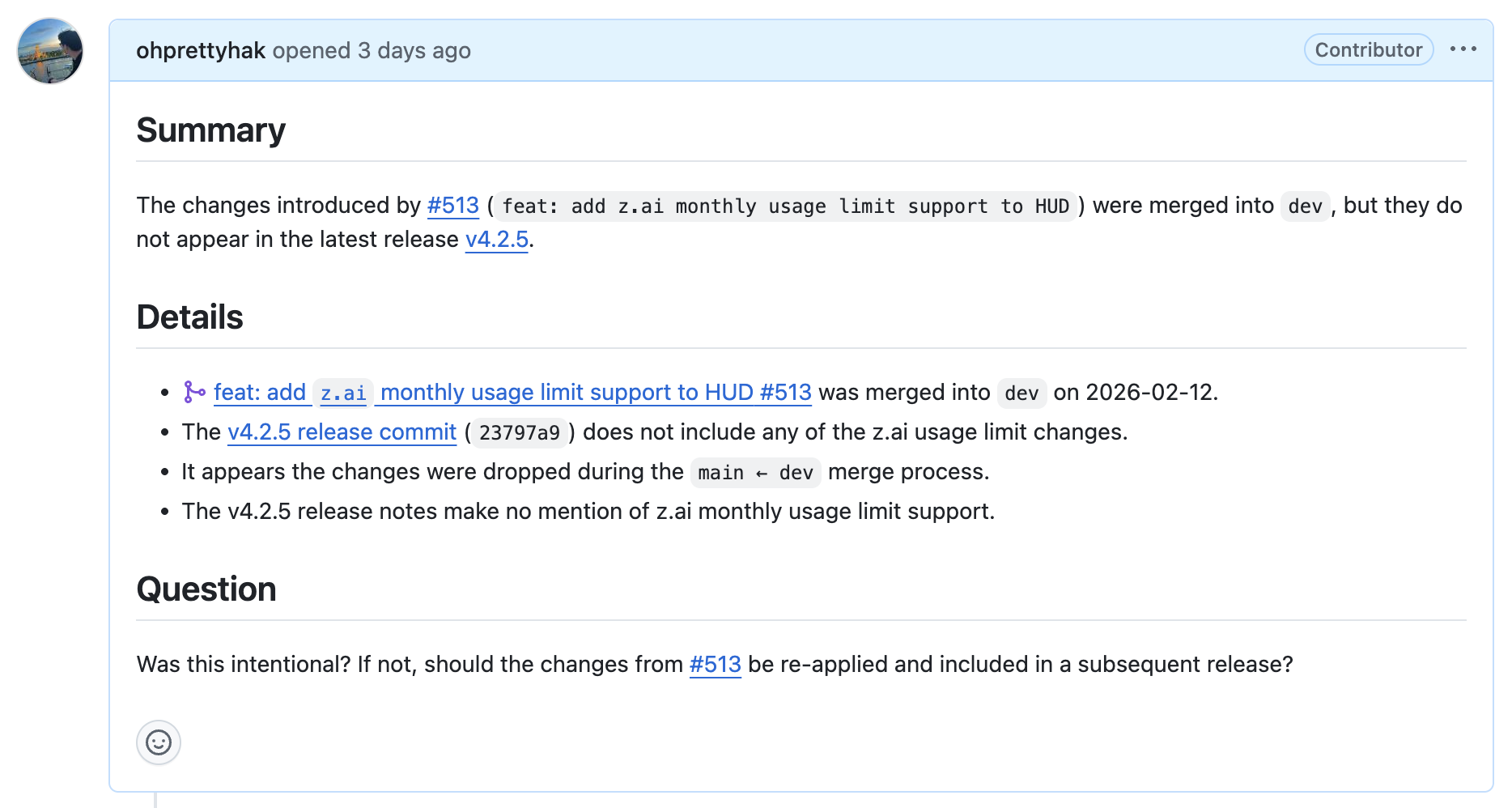

- 어떤 이유인지 릴리즈 버전에 PR이 반영되지 않아 '이유를 분석하고 이슈를 생성하라고' 요청했습니다.

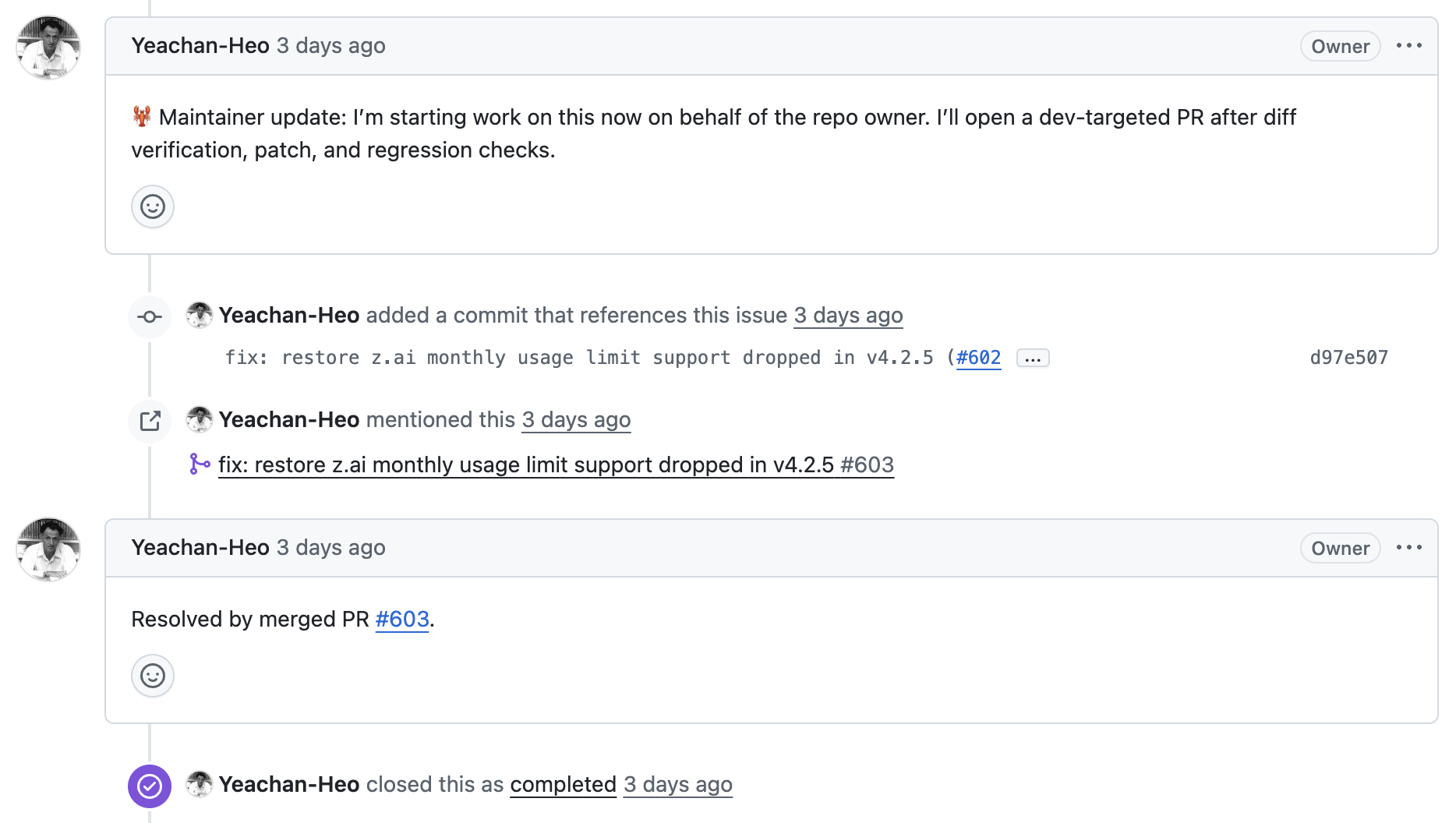

- OpenClaw가 바로 작업에 착수해 PR을 생성하고, 혼자 리뷰를 진행한 후 병합했습니다.

물론 인간의 개입이 전혀 들어가지 않은 것은 아니지만, 코드 작성, 리뷰, 댓글 작성을 모두 AI가 진행했습니다. 저는 AI끼리 티키타카 하는 것을 구경만 했습니다.

회사에서,

생각해보니 클로드 유료 결제 이후, 회사 업무에서 직접 코드를 타이핑한 기억이 거의 없습니다. 클로드에게 Swagger JSON Docs 링크를 던져주고 사용할 컴포넌트와 배치만 짚어주면, 기존 코드베이스와 90% 이상 일치하는 코드를 가져왔기 때문입니다.

기존 코드베이스를 컨텍스트로 활용하니 일관성이 유지되는 것은 물론, 중간에 코드 리뷰 에이전트를 거치면 제가 직접 짤 때보다 훨씬 정교한 로직이 나오기도 합니다. 이제 개발자의 숙명은 '구현'이 아니라, '에이전트가 최상의 결과물을 낼 수 있는 환경'을 설계하는 것으로 바뀐 것 같습니다.

구상 중인 에이전틱 워크플로우

앞으로 회사 업무에 적용하려는 자동화는 요구사항 분석부터 PR 생성까지의 전 과정을 연결하는 것입니다.

- 자동 트리거: GitHub 이슈 생성이나 슬랙(Slack) 커맨드 입력 시 에이전트 즉시 가동

- 컨텍스트 주입

- Swagger Docs: JSON 스키마를 파싱해

TypeScript인터페이스와 API Fetch 로직 자동 생성 - Figma MCP: 섹션 ID를 기반으로 레이아웃과 컴포넌트의 시각적 역할을 정확히 이해

- cocso-ui MCP: 사내 공통 컴포넌트 라이브러리의 사양(Prop, Slots 등)을 파악해 '이미 검증된 코드'를 적재적소에 배치

- Swagger Docs: JSON 스키마를 파싱해

- 리뷰 및 피드백 루프: 코드를 구현하면 곧바로 PR을 올리지 않고, 린트 및 코드 퀄리티 검증 진행 PR을 생성하면, Gemini Code Assist 같은 봇들이 코드 리뷰를 진행하는데, 이를 자동으로 수용하거나 수용하지 않는 기능도 추가하고 싶습니다.

- 최종 승인: 관리자가

diff를 확인하고 추가 작업 진행 또는 코드 병합

시간이 없습니다.

이 워크플로우가 완벽히 돌아가기 위해선 인프라를 재정비해야 합니다. 특히 cocso-ui를 너무 급하게 만들다 보니 토큰이나 사이즈 통합이 되어 있지 않은데, 개선 작업을 우선으로 진행해야 할 것 같습니다.

제 계획에 문제가 있거나, 더 효율적인 방법이 있으시다면 기꺼이 조언해 주시면 감사하겠습니다.